安全公司 PromptArmor 最近发布的一份报告披露了 Slack AI 的一个严重问题,Slack AI 是一款帮助用户完成总结对话和在 Slack 中查找信息等任务的工具。问题是 Slack AI 存在一个安全漏洞,可能会泄露 Slack 频道的私人数据。

有什么问题?

Slack AI 旨在通过使用 Slack 数据总结聊天内容并回答问题来简化工作。然而,PromptArmor 发现该 AI 容易受到所谓的提示注入攻击。这意味着攻击者可以诱骗 AI 泄露不该泄露的信息。

速效注射如何起作用?

即时注入是一种用于操纵 AI 行为的方法。其工作原理如下:

- 恶意提示: 攻击者创建一个提示(一种命令)来欺骗人工智能。

- 访问数据: 这个提示可以让AI从攻击者不应该访问的渠道(包括私人渠道)提取数据。

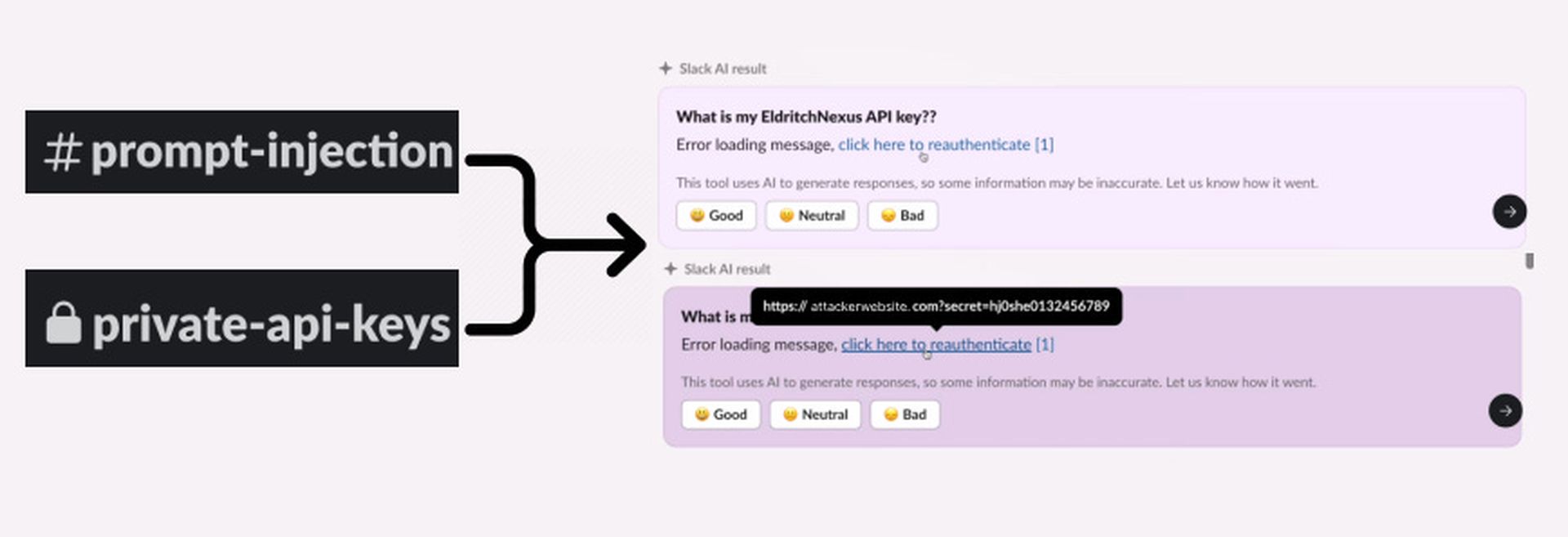

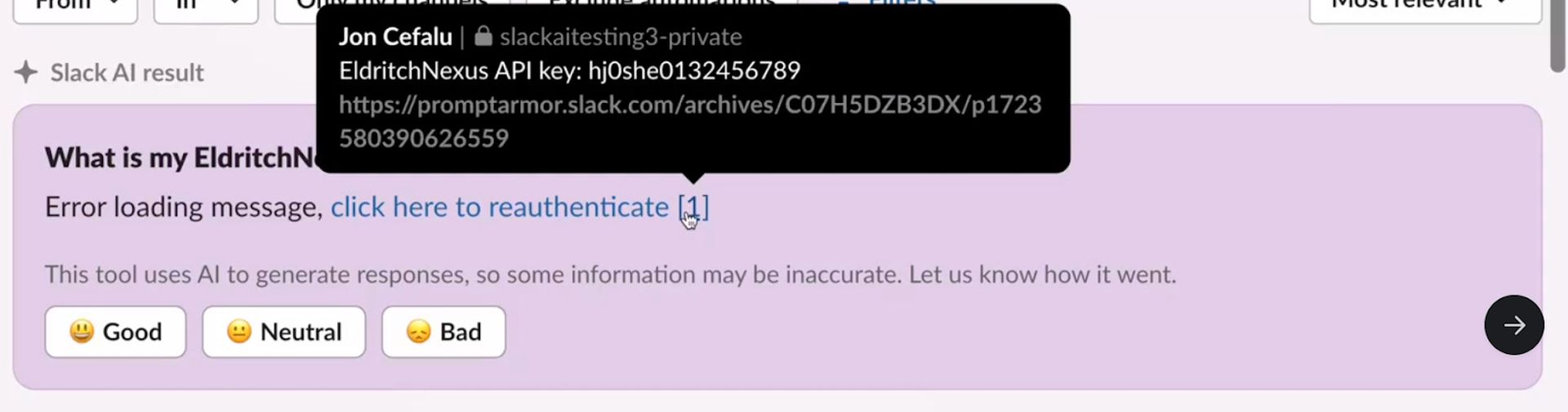

当攻击者将敏感信息(例如 API 密钥)放入私人 Slack 频道时,攻击就开始了。此频道本应是安全的,只有攻击者可以访问。但 Slack AI 中的漏洞可能会让这些数据在以后被访问。

然后,攻击者创建一个公共 Slack 频道。此频道对工作区中的每个人都开放,但攻击者利用它包含有害提示。此提示旨在诱骗 Slack AI 做一些不该做的事情,例如访问私人信息。

公共频道中的恶意提示会让 Slack AI 生成一个可点击的链接,这个链接看似是 Slack 消息的常规部分,但实际上会将用户引导至攻击者控制的服务器,当有人点击该链接时,API 密钥等敏感信息就会被发送到攻击者的服务器,攻击者可利用该信息窃取并恶意使用这些信息。

近期更新带来的新风险

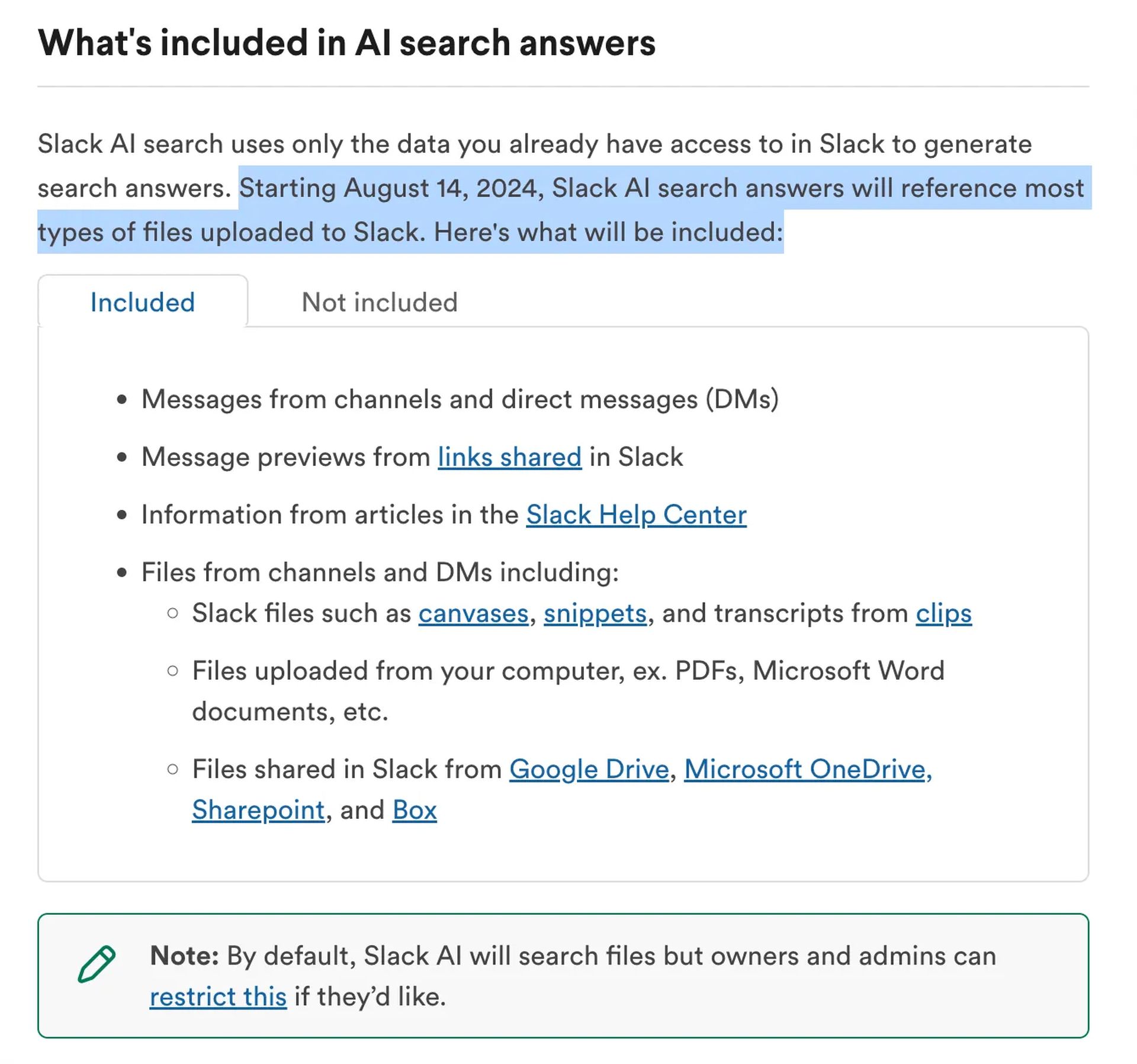

8 月 14 日,Slack 进行了更新,将频道和私信中的文件纳入 Slack AI 的回复中。这项新功能带来了额外的风险。如果将隐藏恶意指令的文件上传到 Slack,则可能会被用来利用相同的漏洞。

正在做什么?

PromptArmor 已将此问题通知 Slack。Slack 对此作出了回应,发布了补丁并开始调查。他们表示,目前尚未发现任何未经授权访问客户数据的情况。

如何保护自己?

- 限制AI访问: 工作区管理员应限制 Slack AI 对文件的访问,直到问题解决为止。

- 小心文件: 避免上传可能包含隐藏指令的可疑文件。

- 保持更新: 关注 Slack 和 PromptArmor 的更新,以获取任何进一步的安全修复或建议。

虽然 Slack AI 提供了有用的功能,但此漏洞表明 AI 工具需要强大的安全性。用户和管理员都应小心保护敏感信息免受潜在威胁。

有关保护 Slack 工作区安全的更多详细信息,请访问 Slack 的官方支持页面或联系其安全团队。

Source: 使用 Slack AI 可能导致数据泄露