Apple 已决定进一步打击儿童色情内容。 该公司创建了一个新的扫描和加密系统,它将跟踪用户的照片以搜索可疑内容。 基于机器学习的新功能暂时不会在部分国家推出,会先在美国进行测试,但已经引起网络安全专家的怀疑。

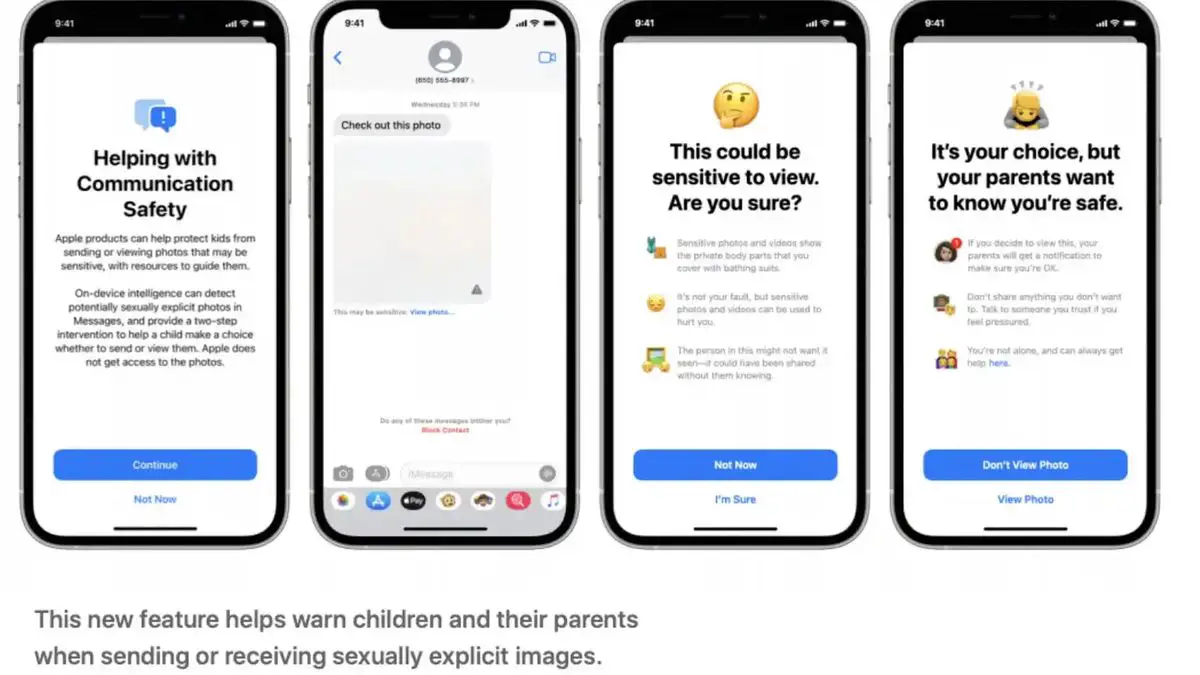

该公司因此证实了约翰霍普金斯大学密码学教授马修格林周四在推特上提出的信息。 从现在起,如果 iPhone 用户尝试通过 iMessage 发送的任何图像涉嫌灌输对未成年人的性虐待,他们将收到警报。

“Messages 使用设备上的机器学习来分析图像附件并确定照片是否具有色情内容。 该功能的设计目的是让 Apple 无法访问 Messages”。

它是如何工作的?

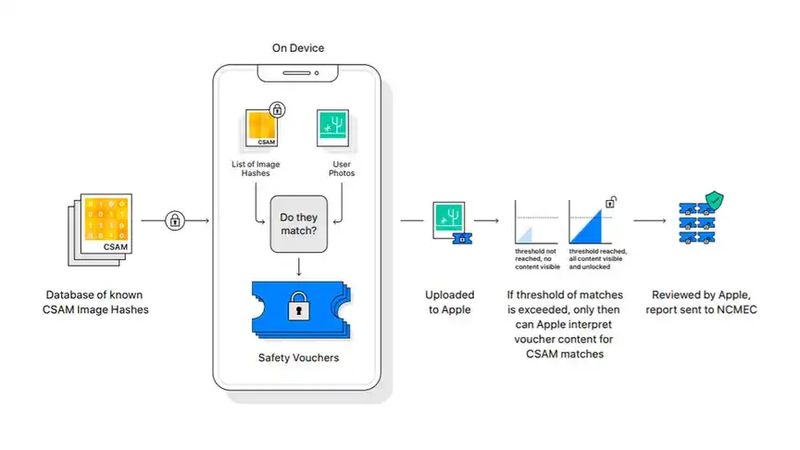

该技术将用于 iOS、macOS、WatchOS 和 iMessages,其中将分析用户打算共享的所有图像。 为此,他们求助于称为 NeuralHash 的机器学习算法。

哈希技术无需查看或打开文件即可分析图像。 它将每张照片转换为描述其内容的唯一编号,例如数字指纹,但任何用户都无法理解。

将该代码与公司确定为可疑内容的代码进行比较后,如果在一个代码和另一个代码之间检测到足够多的匹配项,则会创建警报,模糊图像并阻止其共享。

如果孩子想要发送被归类为可疑的内容,Apple 会确保父母能够收到警报。 当局还可以收到这些比赛的警报,以便人工团队可以查看图像。

马修格林 在他的 Twitter 帐户中解释说,这项技术可能会产生误报,因为它们不是很准确:“这是故意的。 它们旨在查找看起来像坏图像的图像,即使它们已被调整大小、压缩等。” 该公司否认了这一说法:“系统错误标记帐户的风险极低。 此外,Apple 会手动审查向 NCMEC 提交的所有报告,以确保报告的准确性。”

隐私风险

网络安全专家谴责说,这可能是追捕罪犯、恋童癖者和恐怖分子的关键工具,但同时也对无辜公民的隐私构成威胁,也是极权主义政权非常有用的武器。

这个新工具的问题在于他们将在哪里寻找这些相似之处。 存储在设备上和 iCloud 中的照片在 Apple 服务器上加密存储,但正如专家解释的那样,解密这些代码的密钥是 Apple 的财产。

唯一具有端到端加密 (E2E) 的是 iMessages 的那些,就像 WhatsApp,从一台设备到另一台设备都受到保护,因此除了用户之外没有人可以看到它们。 理论上,这就是苹果新系统的用武之地。

这种内容分析并不新鲜。 Facebook 会扫描其社交网络(Facebook 和 Instagram)上的裸体帖子。 Apple 还使用散列系统来查找通过电子邮件发送的虐待儿童图像,类似于 Gmail 和其他云电子邮件提供商的系统,这些系统不受端到端加密的保护。

格林认为这项技术发出了一个令人不安的信息。 “不管苹果的长期计划如何,他们都发出了一个非常明确的信号。 (…) 构建系统来扫描用户手机中的违禁内容是安全的,”他在他的 Twitter 个人资料中解释道。

然而,并非所有网络安全专家都如此挑剔。 加州大学伯克利分校国际计算机科学研究所的高级研究员 Nicholas Weaver 向 Motherboard 保证,Apple 的新消息功能“似乎是一个非常好的主意”。 “总体而言,Apple 的方法似乎经过深思熟虑,既有效又最大限度地保护了隐私,”他补充道。