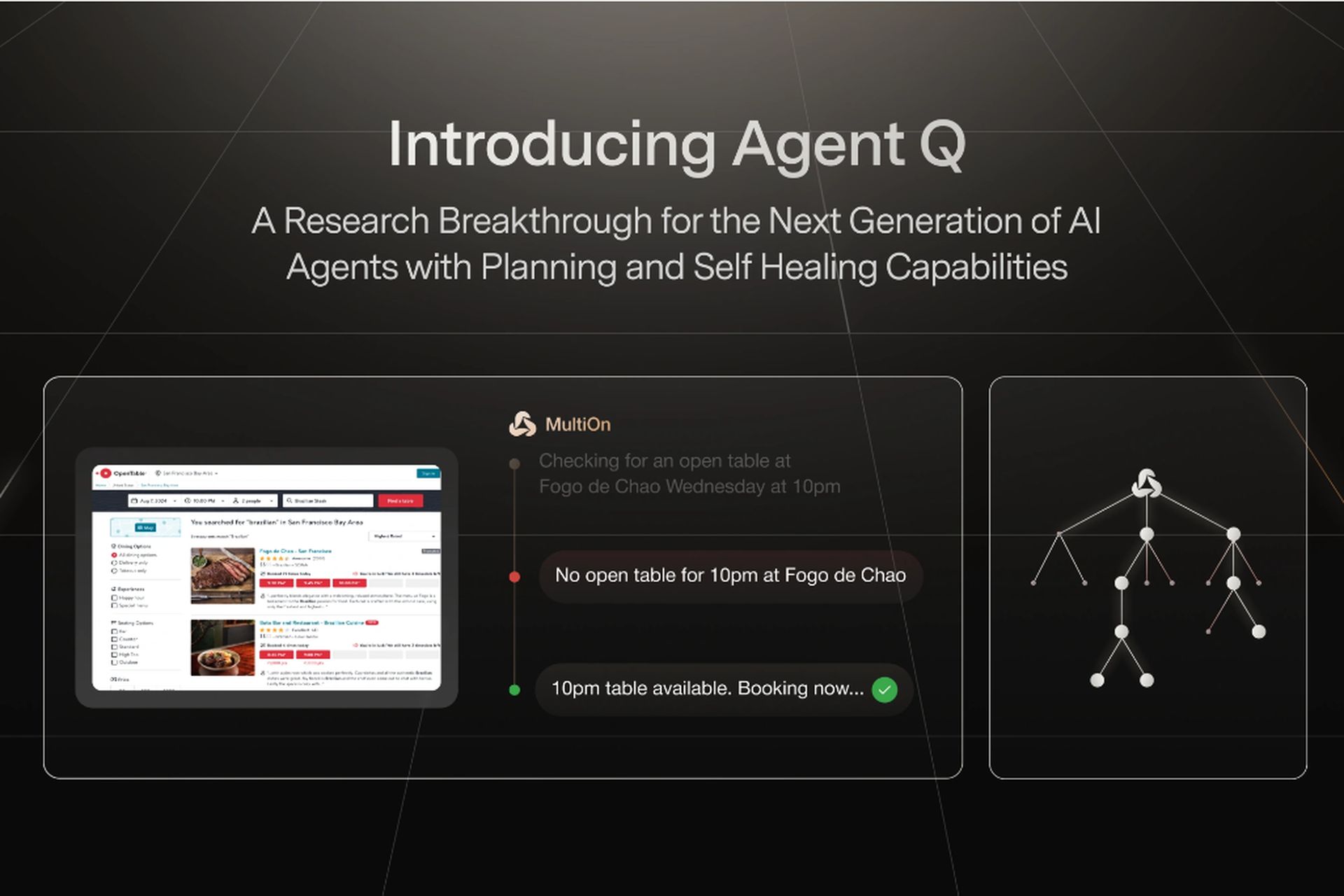

MultiON AI Agent Q 是人工智能领域的另一项重要发展。人工智能领域几乎所有的发展都是重大的,所以这几乎已经成为常态。MultiON AI Agent Q 所依赖的技术是为自主在线代理创建的,旨在解决人工智能开发中最困难的元素之一:允许大型语言模型 (LLM) 驾驭复杂的动态设置。

借助 MultiON AI Agent Q,AI 将能够理解 AI 的语言

尽管自然语言处理取得了进展,但当前的人工智能模型在交互环境中往往表现不佳,特别是在需要多步推理的任务中。问题在于传统的训练方法,它们严重依赖静态数据集。这些方法无法充分让人工智能代理为现实世界交互的不可预测性做好准备,因为现实世界中的决策必须即时做出,而且错误很容易加剧。

这就是 MultiON AI Agent Q 发挥作用的地方。MultiON AI Agent Q 的关键创新在于其规划和自我修复能力——这些功能对于 自主网络代理. 通过结合引导式 蒙特卡洛树搜索 (MCTS)和 人工智能的自我批评,Q 探员提供了更多 稳健且适应性强 人工智能训练的方法。这确保了代理不仅仅是被动地从预定义数据中学习,而是通过与环境的交互而主动改进。

解析 MultiON AI Agent Q 技术

MultiON AI Agent Q 的核心是几种先进技术的组合,这些技术共同努力克服现有 AI 代理的局限性:

- 最重要的组成部分之一是引导 移动通信系统,使人工智能能够自主探索不同的动作和网页。这种技术平衡了探索和利用的需求,使人工智能能够从各种可能的情况中学习。通过生成不同的最佳轨迹,代理可以更好地执行复杂的决策任务。

- MultiON AI Agent Q 的另一个关键方面是 AI自我批评机制此功能通过提供以下功能帮助代理改进其决策: 逐步反馈这对于长期任务尤其重要,因为缺乏即时反馈会阻碍学习。人工智能自我批评使代理能够不断改进,即使在反馈不频繁的情况下也是如此。

- 最后, 直接偏好优化 偏好向量优化 (DPO) 算法在模型微调中起着重要作用。DPO 算法从通过 MCTS 生成的数据中生成偏好对,允许代理从中学习 成功和失败的道路这种非策略训练方法在动态环境中尤其有效,因为从过去的错误中吸取教训的能力至关重要。

现实世界的影响:MultiON AI Agent Q 的验证

MultiON AI Agent Q 的功能包括 不仅仅是理论上的;它们已在现实环境中得到验证。在与 Open Table 的一项实验中,MultiON 的代理提高了 LLaMa-3 的性能 模型 经过一天的自主数据收集,成功率从 18.6% 至 81.7%,进一步完善,成功率提高到 95.4%。这些结果突出了 MultiON AI Agent Q 中使用的技术的有效性,并展示了其彻底改变自主网络导航的潜力。

宣布我们最新的研究突破:

Agent Q——带来具有规划和AI自我修复功能的下一代AI代理,比LLama 3的基线零样本性能提高了340%! pic.twitter.com/EdypdDn26M

— MultiOn (@MultiOn_AI) 2024 年 8 月 13 日

MultiON AI Agent Q 不仅仅是一项技术创新,因为虽然 AI 仍处于起步阶段,但构建一个理解 AI 的 AI 却是一件非常不同的事情。通过结合高级搜索技术、AI 自我批评和强化学习,MultiON AI Agent Q 解决了长期困扰动态环境中 AI 代理的挑战。随着 MultiON 继续完善和开发这些技术,潜在的应用非常广泛。在 MultiON AI Agent Q 的领导下,智能自主网络代理的未来比以往任何时候都更加光明。

为了保持领先地位,开发人员和用户都可以期待今年晚些时候发布的 MultiON AI Agent Q。对于那些渴望成为首批体验这项突破性技术的人,下一步就是加入等候名单。

特色图片来源:MultiON

Source: MultiON AI Agent Q 如何改变 AI 训练方法