Nvidia 最近推出了 NVIDIA H200,正在彻底改变人工智能计算领域。 这个尖端平台基于 NVIDIA Hopper 构建 架构,拥有强大的NVIDIA H200 Tensor Core GPU,配备 高级记忆 旨在解决 大量数据负载 适用于生成式 AI 和高性能计算 (HPC) 工作负载。

架构,拥有强大的NVIDIA H200 Tensor Core GPU,配备 高级记忆 旨在解决 大量数据负载 适用于生成式 AI 和高性能计算 (HPC) 工作负载。

在本文中,我们将深入研究最近发布的产品,并提供有关新款 NVIDIA H200 的尽可能多的详细信息。

NVIDIA H200 的强大功能

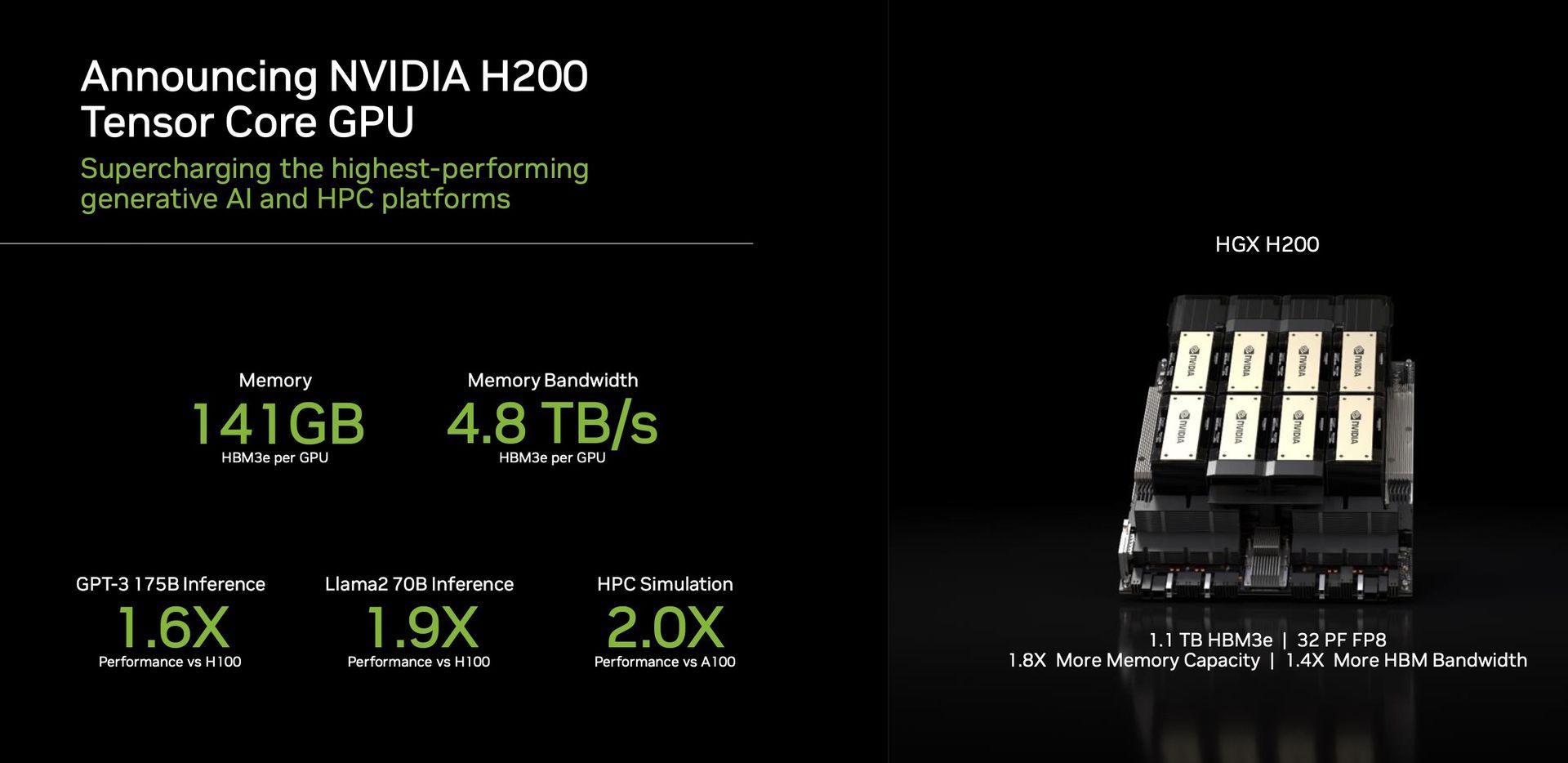

H200的一个突出特点是 它对 HBM3e 的利用, 第一个提供更快、更大内存的 GPU。 这一进步推动了生成式人工智能和大型语言模型的加速发展,同时突破了 科学计算 适用于 HPC 工作负载。 借助 HBM3e,H200 提供了令人印象深刻的 141GB内存 以惊人的 每秒 4.8 TB。 这意味着容量几乎翻倍 带宽增加 2.4 倍 与其前身 NVIDIA A100 相比。

性能与应用

H200,由 NVIDIA NVLink 提供支持 和 NV 开关

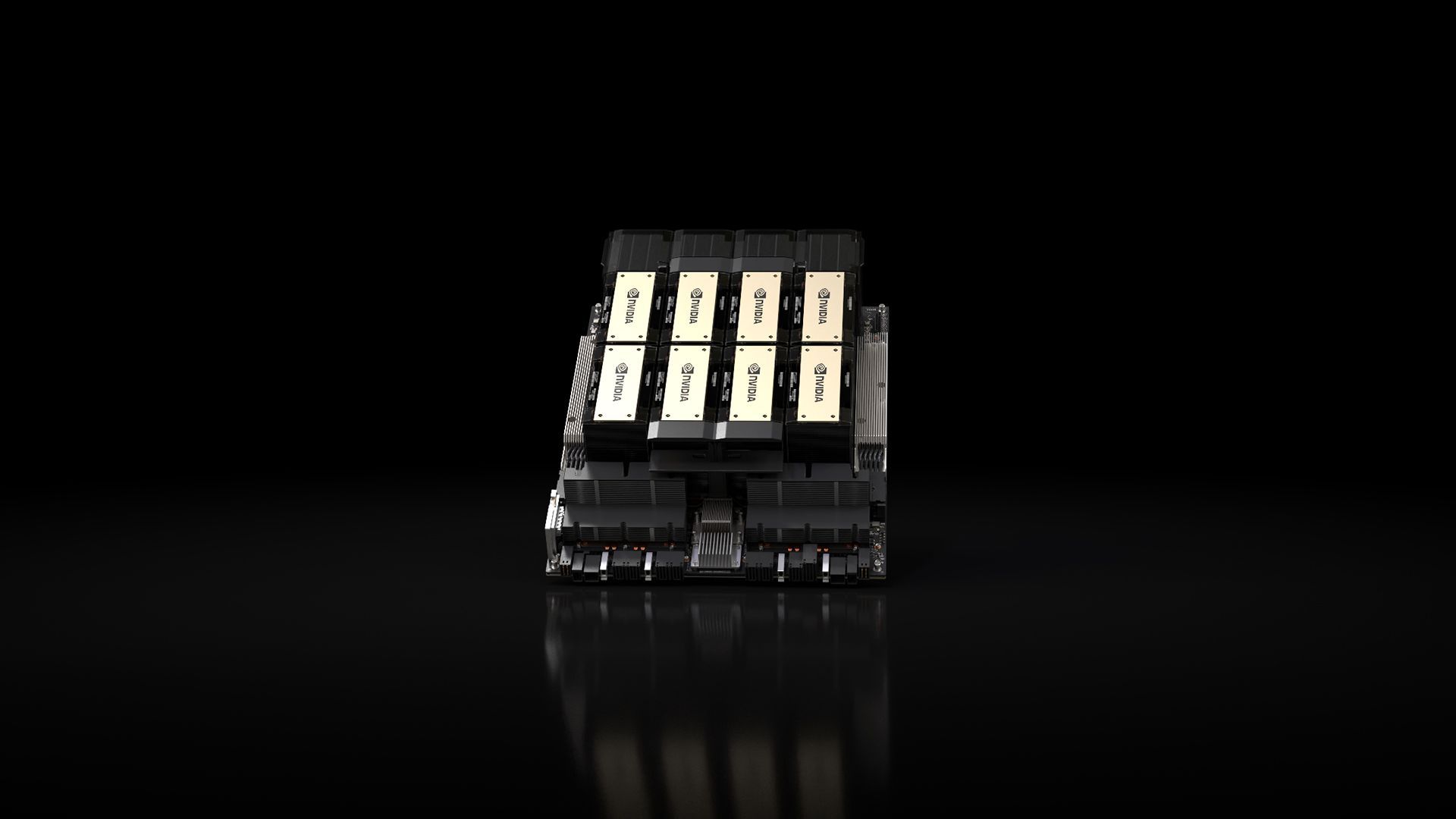

和 NV 开关 高速互连,承诺 无与伦比的性能 跨各种应用程序工作负载。 这包括其在 LLM(大型语言模型)训练和模型推理方面的实力,其规模超过了大型语言模型。 1750 亿个参数。 八路 HGX H200 凭借提供超过 FP8 深度为 32 petaflops 学习计算 和 总计 1.1TB 的高带宽内存, 确保生成式人工智能和高性能计算应用程序的最佳性能。

高速互连,承诺 无与伦比的性能 跨各种应用程序工作负载。 这包括其在 LLM(大型语言模型)训练和模型推理方面的实力,其规模超过了大型语言模型。 1750 亿个参数。 八路 HGX H200 凭借提供超过 FP8 深度为 32 petaflops 学习计算 和 总计 1.1TB 的高带宽内存, 确保生成式人工智能和高性能计算应用程序的最佳性能。

Nvidia 的 GPU 已成为 关键的 在生成人工智能模型领域,在其开发和部署中发挥着至关重要的作用。 Nvidia 的 GPU 旨在处理训练和运行这些模型所需的大规模并行计算,在以下任务中表现出色 图像生成 和 自然语言 加工。 并行处理架构允许这些 GPU 执行 同时进行大量计算, 从而大幅加速生成人工智能模型过程。

H200 证明了 Nvidia 的承诺 持续创新,业绩飞跃。 以 Hopper 架构的成功为基础,不断进行软件增强,包括最近发布的 NVIDIA TensorRT 等开源库 -LLM,持续提升平台性能。 NVIDIA H200 的推出有望进一步飞跃,人们的期望接近 推理速度加倍 与它的前身 H100 相比,Llama 2 等模型(一个拥有 700 亿参数的 LLM)。

-LLM,持续提升平台性能。 NVIDIA H200 的推出有望进一步飞跃,人们的期望接近 推理速度加倍 与它的前身 H100 相比,Llama 2 等模型(一个拥有 700 亿参数的 LLM)。

多功能性和可用性

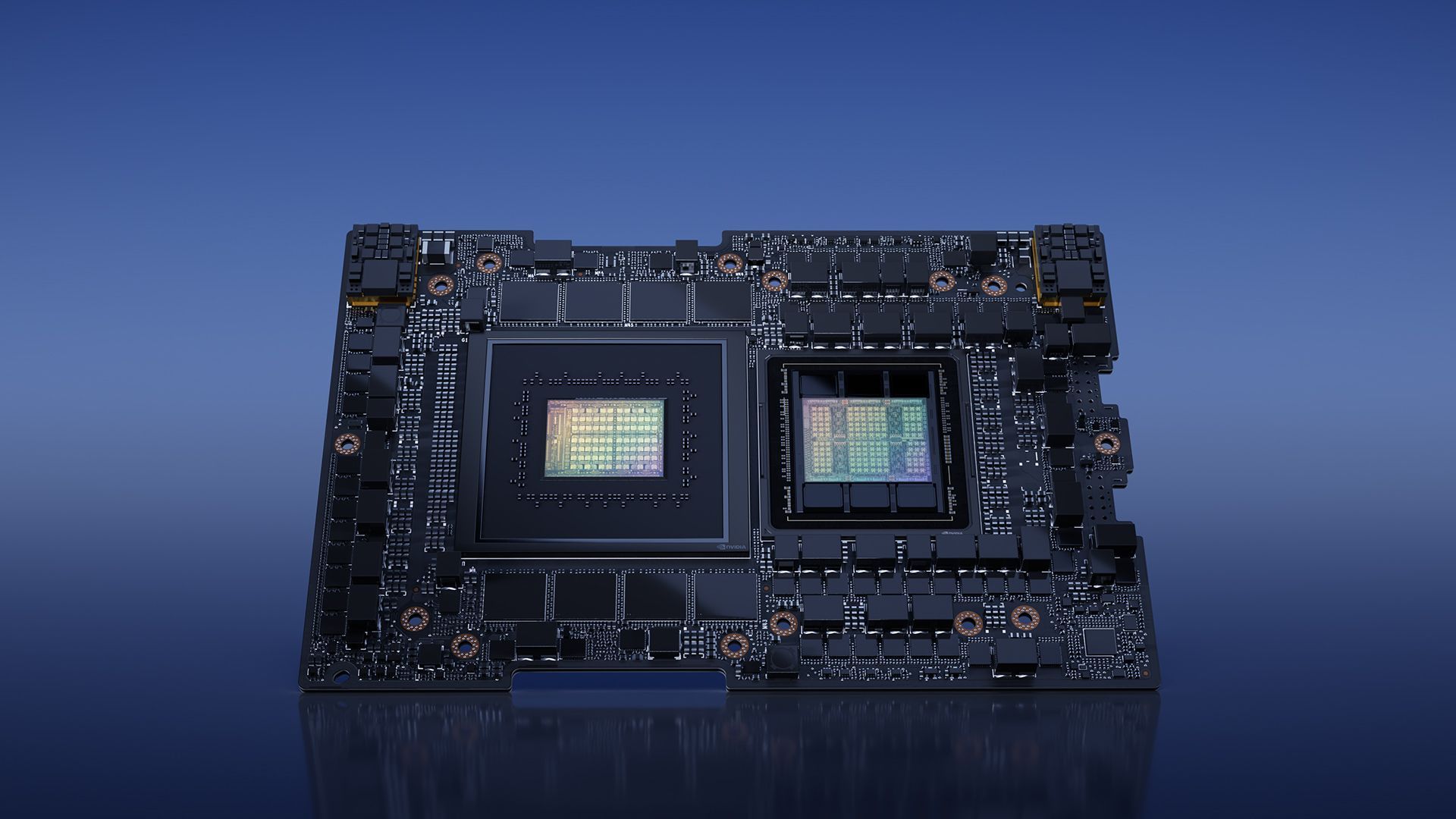

英伟达确保 多功能性 H200 提供各种外形尺寸,例如具有四路和八路配置的 NVIDIA HGX H200 服务器主板。 这些配置与 HGX H100 系统的硬件和软件兼容。 此外,NVIDIA H200 可在 NVIDIA GH200 Grace Hopper 中使用 采用 HBM3e 的超级芯片,可满足不同的数据中心设置,包括本地、云、混合云和边缘环境。 服务器制造商合作伙伴的全球生态系统可以 无缝更新现有系统 与 H200 一起使用,确保广泛的可访问性。

采用 HBM3e 的超级芯片,可满足不同的数据中心设置,包括本地、云、混合云和边缘环境。 服务器制造商合作伙伴的全球生态系统可以 无缝更新现有系统 与 H200 一起使用,确保广泛的可访问性。

爱好者和行业专家热切等待 HGX H200 系统的发布,该系统将于 2019 年上市。 2024 年第二季度。 亚马逊网络服务、谷歌云、微软 Azure 和 Oracle 云基础设施等全球知名企业均在其中 第一波云服务商 准备明年部署基于 H200 的实例。

建筑(图片来源)

建筑(图片来源)总之,NVIDIA H200 凭借其突破性的功能和性能能力,将 重新定义人工智能计算的格局。 H200 将于 2024 年第二季度上市,将为全球的开发者和企业提供支持, 加速人工智能应用的开发和部署 从语音到超大规模推理。

同时,如果您对领先的科技公司感兴趣,请务必查看我们关于 Nvidia 和 AMD 如何开发“基于 ARM 的芯片”的文章。

特色图片来源: 英伟达

Source: NVIDIA H200 的推出引起了 AI 领域的高度期待