建立在 耳语,牛津大学的研究人员正在开发 WhisperX 以在 长篇语音转录.

由于广泛的在线数据集的可用性,弱监督和无监督训练方法在各种音频处理任务上表现出了出色的性能,包括 嗓音 认出, 扬声器 认出, 演讲 分离, 和 关键词 发现.

Whisper 和 WhisperX 是如何工作的?

Whisper,一个语音识别系统,由 牛津研究人员,在更大范围内利用这些大量信息。 他们展示了基本编码器-解码器转换器的弱监督预训练如何能够在公认的基准上实现零样本多语言语音转录 125,000小时的英文翻译数据 和 68万小时的嘈杂语音训练数据 96 种其他语言。

虽然大多数学术基准由简短的陈述组成,但在会议、播客和视频等现实环境中,经常需要转录可能持续数小时或数分钟的冗长音频。

变压器设计采用 自动语音识别 由于内存限制,(ASR) 模型不允许转录任意长的输入音频(在 Whisper 的情况下最长 30 秒)。

最近的研究采用启发式滑动窗口方法,由于以下原因容易出错 不完整的音频,如果某些单词位于输入段的开头或结尾,则可能会丢失或错误转录; 和 重叠音频,当模型两次处理相同的语音时,这可能会导致转录不一致。

Whisper 提出了一种缓冲转录技术,可以确定 输入窗口应该移动多远 基于 准确的时间戳预测. 这种方法容易受到严重漂移的影响,因为一个窗口中的时间戳不准确可能会导致后续窗口中出现问题。

他们使用一些自制的启发式方法来尝试消除这些错误,尽管他们经常这样做并不成功。 Whisper 的链接解码,它使用单个编码器解码器来解码时间戳和转录, 容易出现自动回归语言生成的常见问题,特别是幻觉和重复。

长格式和其他对时间戳敏感的活动,例如 说话人二元化, 唇读, 和 视听学习 受此不利影响,以及缓冲转录。

Whisper 论文声称训练语料库的很大一部分包括 资料不全 (缺少时间戳信息的音频转录配对),由标记 |nottimestamps|> 表示。 无意中牺牲了语音转录的性能 不太准确的时间戳 在缩放不完美和嘈杂的转录材料时进行预测。

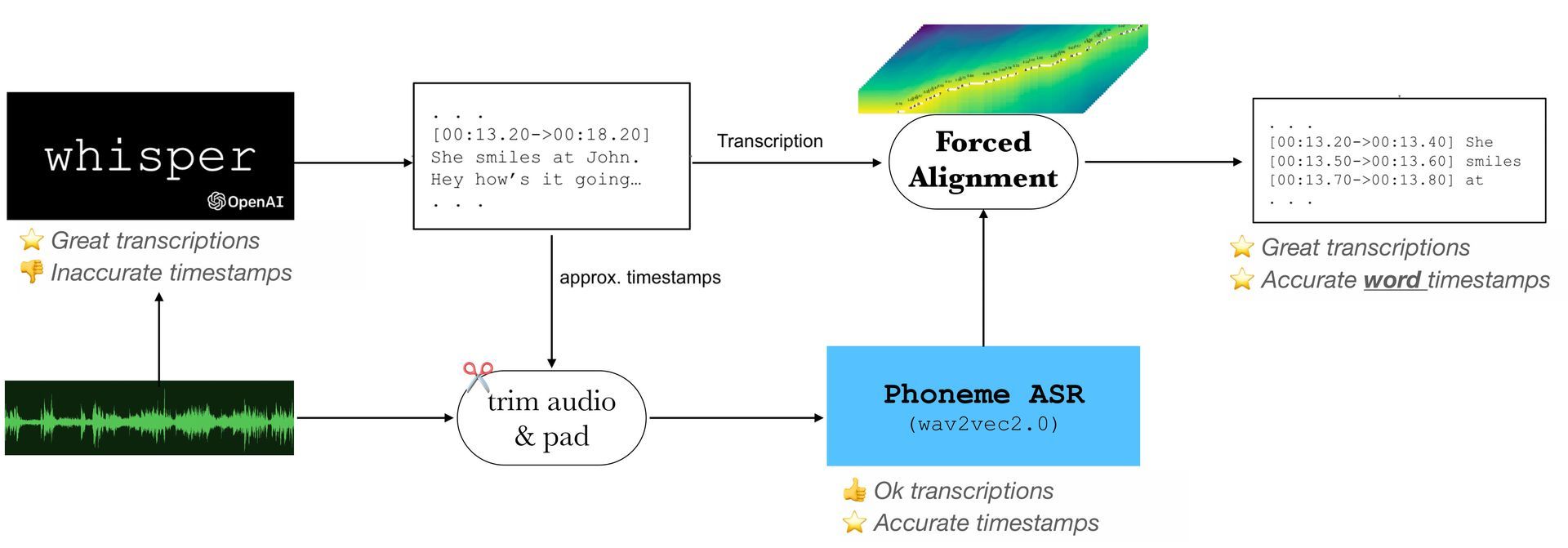

因此,在使用附加模块时,语音和文字记录必须正确对齐。 在 ”强制对齐“,语音转录和音频波形在单词或音素级别同步。 这 隐马尔可夫模型 (HMM) 框架和可能状态对齐的副产品经常用于声学电话模型的训练。

外部边界校正模型经常用于校正这些单词或电话号码的时间戳。 由于迅速扩张 基于深度学习的方法,最近的一些研究使用深度学习技术进行强制对齐,例如应用双向注意力矩阵或使用端到端训练模型进行 CTC 分割。

通过将最先进的 ASR 模型与简单的音素识别模型相结合,可以实现进一步的改进,这两个模型都是使用重要的大规模数据集构建的。

当 WhisperX 出现时

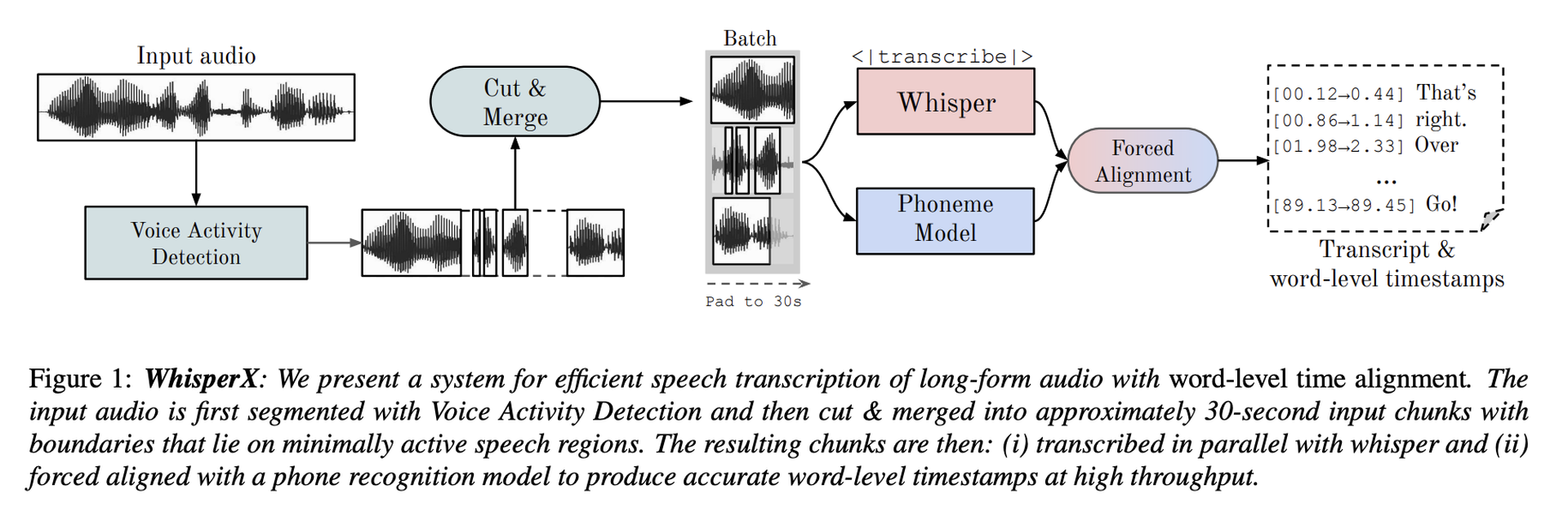

他们提议 耳语X,一种使用精确的单词级时间戳对冗长录音进行准确语音转录的技术,作为这些问题的解决方案。 此外 耳语转录,它还包括以下三个步骤:

- 使用外部语音活动检测 (VAD) 模型对传入音频进行预分段。

- 生成的 VAD 片段被划分并合并为大约 30 秒的输入块,并以活动量最少的语音区域为边界。

- 为了提供准确的词级时间戳,他们需要与外部音素模型对齐。

随着人工智能和基于文本的人工智能聊天机器人的兴起,文本转语音和语音识别程序的需求量很大。 就在本周,ChatGPT 视频聊天应用程序 Call Annie AI 发布,试图利用这一不断增长的需求。 尽管 WhisperX 的未来在其可能性方面尚不完全明朗,但我们可以说跟踪其进展绝对值得。

Source: Whisper 和 WhisperX:来自牛津大学研究人员的时间准确的语音转录系统