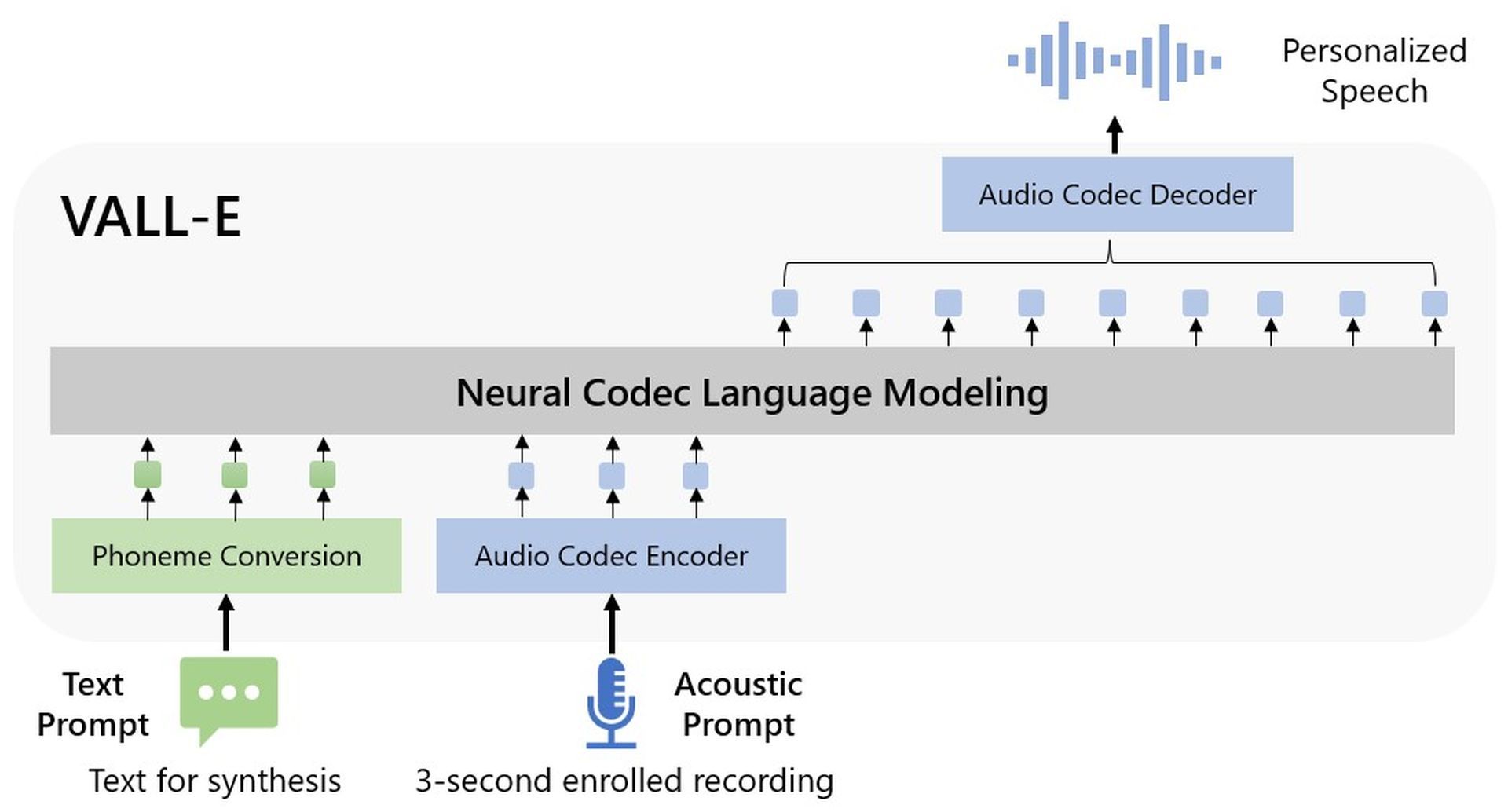

微软在文本到语音合成方面的尝试,Microsoft VALL-E 已在该公司发表的一篇论文中宣布。 音频模型只需要一个 3 秒的音频文件来处理给定的输入。

Microsoft VALL-E 是一种用于文本到语音合成 (TTS) 的新型语言模型方法,它利用音频编解码器代码作为中间表示,由 Microsoft 刚刚推出。 它在 60,000 小时的英语语音数据上进行了预训练,然后在零样本情况下展示了上下文学习能力。

微软 VALL-E 可以产生高质量的个性化语音,只需录制三秒钟的倾斜扬声器作为声学刺激的注册录音。 这样做不需要额外的结构工程、预先设计的声学特性或微调。 它支持上下文学习和基于提示的零镜头 TTS 方法。 似乎 TTS 的半监督数据的扩展没有得到充分利用,因为微软已经使用了大量的半监督数据在说话者维度构建了一个通用的 TTS 系统。

您可以使用 Microsoft VALL-E 做什么?

根据研究人员的说法,Microsoft VALL-E 是一种“神经编解码器语言模型”,它使用“源自预先存在的神经音频编解码器模型”的离散代码进行训练。 根据声明,它接受了 6 万小时的语音训练,“是现有系统的数百倍”。 与之前明显是机器人的尝试相比,这些例子令人信服,尽管人工智能已经存在了一段时间,可以逼真地模仿人类的语言。

根据研究人员的提示,Microsoft VALL-E 可以“保留说话者的情绪和听觉环境”。 尽管令人印象深刻,但技术距离取代配音演员还有很长的路要走,因为在表演过程中找到合适的语气和情感是不同的。 即使是 Microsoft VALL-E 的高级版本也无法像熟练的专业人员那样执行,但企业通常将成本效益置于质量之上。

在 Microsoft 的 GitHub 演示中,您可以收听一些示例。

微软 VALL-E 功能

虽然Microsoft VALL-E 很新,但它已经具备许多功能。

多样性的综合:因为 Microsoft VALL-E 使用基于采样的技术生成离散标记,所以它的输出对于相同的输入文本是不同的。 因此,它可以使用各种随机种子合成不同的个性化语音样本。

声环境维护:Microsoft VALL-E 可以提供自定义语音,同时保持扬声器提示的声学环境。 与基线相比,VALL-E 在具有更多声学变量的大数据集上进行训练。 音频和转录是使用 Fisher 数据集中的样本生成的。

说话人的情绪维护:使用情感声音数据库作为例如音频提示的资源,Microsoft VALL-E 可以创建定制的语音,同时保持说话者提示的情感基调。 传统方法通过将语音与受监督的情感 TTS 数据集中的转录和情感标签相关联来训练模型。 即使在零镜头的情况下,VALL-E 也能将情绪保持在提示中。

Microsoft VALL-E 在模型结构、数据覆盖和综合稳健性方面仍然存在问题。

Microsoft WALL-E 是如何工作的?

微软使用由 Meta 整合的音频库 LibriLight 来训练 VALL-voice E 的合成技能。 60,000 小时的英语演讲中的大部分来自 LibriVox 公共领域有声读物,由 7,000 多个不同的人讲过。 三秒样本中的语音必须与训练数据中的语音非常相似,VALL-E 才能获得满意的结果。

Microsoft 在 VALL-E 示例页面上提供了数十个 AI 模型的音频示例。 “Speaker Prompt”是样本之一,是 VALL-E 被指示模仿的三秒钟音频。 “Ground Truth”是该演讲者先前录制的摘录,用作基准(有点像实验中的“控制”)。 “VALL-E”样本是 VALL-E 模型的输出,“Baseline”样本是传统文本到语音合成方法生成的合成示例。

虽然微软 VALL-E 创造了历史,成为 2023 年第一个但肯定不是最后一个主要 AI 项目,这家技术巨头为 2022 年最后几周发布的 OpenAI Point-E 提供了资金支持。

Source: 微软 VALL-E 解释:A Voice DALL-E